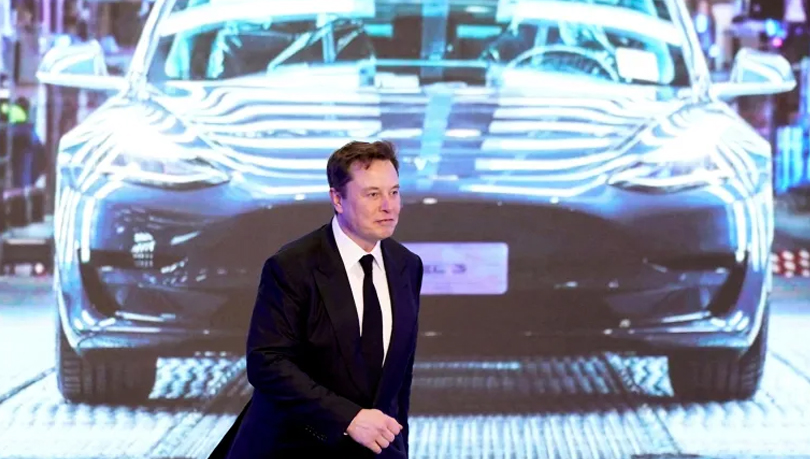

يحذر إيلون ماسك منذ وقت طويل من مخاطر الذكاء الاصطناعي ويصف المشككين بخطره بأنهم أقل ذكاء من سواهم، ووصل الأمر بماسك إلى القول بأن الذكاء الاصطناعي أشد خطرًا من حرب نووية. وأحد مآخذ ماسك على الذكاء الاصطناعي أنه سيصبح بديلًا عن العمال البشريين، وبأن نسخة شريرة منه ربما تقرر الاستغناء عن البشر.

الفخ المعرفي

وانتقد ماسك حديثًا، الأشخاص الأذكياء ممن يفترضون أنه يستحيل على الذكاء الاصطناعي خداعهم، معتبرًا أنهم يقللون من مدى الخداع الذي يمكن للذكاء الاصطناعي القيام به.

وقال ماسك «يجب أن نقلق من مدى تقدم الذكاء الاصطناعي، الأشخاص الذين أرى أنهم الأكثر خطأ حيال الذكاء الاصطناعي هم أصحاب الذكاء الحاد لكن هذا يمنعهم من تخيل إمكانية تفوق ذكاء الحاسوب عليهم، وهذا خلل في منطقهم، إنهم أغبياء أكثر مما يعتقدون بكثير» وفقًا لموقع بزنيس إنسايدر.

قرع أجراس الإنذار

ولا يشارك جميع أقران ماسك مخاوفه، فهي نابعة في بعض الأحيان مع ادعاءات غير مدعومة بأدلة عن أخطار الذكاء الاصطناعي، وبغض النظر عن تحذيراته، تبدو حلوله منطقية؛ مثل ضرورة تفعيل الرقابة وتنظيم أبحاث الذكاء الاصطناعي وتوفير حماية وقائية ضد التقنية المسيئة أو غير المسؤولة.

هواجس

وترتفع بين الحين والآخر أصوات تعود لخبراء في القطاع محذرة من تنامي اعتماد البشرية على خوارزميات الذكاء الاصطناعي وتطوير التعلم العميق للآلات ووصوله إلى قدرات غير مسبوقة من السيطرة والتلاعب بالمجتمعات، على الرغم من الإيجابيات المترتبة على تطويره وقدرته على تحسين العالم ومكافحة الأمراض ورفع مستويات الرعاية الصحية وتخليصنا من مهام مجهدة تهيمن على حياتنا.

استخدامات شريرة

وقال العالِم كينث ستانلي، الأستاذ الجامعي في جامعة فلوريدا الوسطى، والمدير الهندسي لمخابر أوبر للذكاء الاصطناعي إن «أكثر الأمور مدعاة للقلق، استخدام الذكاء الاصطناعي لإيذاء البشر، وتوجد تطبيقات كثيرة تجعلك تتخيل حدوث ذلك، وعلينا أن نكون أكثر حذرًا، وأن لا نسمح لهذا الجانب السيئ بالتجسد على أرض الواقع. إن فهم كيفية استمرار ثقتنا بالذكاء الاصطناعي؛ سؤال صعب جدًا وله أبعاد كثيرة تتجاوز الأبعاد العلمية، ما يُبرز الحاجة الملحة لمشاركة المجتمع كله في الإجابة عليه.»

وأضاف في لقاء خاص مع مرصد المستقبل إن «إساءة استخدام جميع أنواع التقنية أمر وارد، وأظن أن الذكاء الاصطناعي ليس إلا مثالًا آخر على ذلك، ولطالما كافح البشر لمنع استخدام التقنيات الحديثة لأغراض شريرة، ويبقى إقدامنا على وضع ضوابط وضمانات صحيحة، كفيلًا بجعلها آمنة.»

وتابع «لا يمكنني الجزم اليوم بشأن قدرتنا على ضبط الأمور مستقبلًا، وما يجب أن نفعله حيال ذلك، لكن يمكنني أن أحذر من آلية التعاطي مع الذكاء الاصطناعي، وضرورة اتخاذ جانب الحيطة خلال استجابتنا لتأثيراته، وأن نطور طرائق تعاملنا معه بالتدريج.»

وقال إيركلي بيريدز رئيس مركز الذكاء الاصطناعي والروبوتي في معهد الأمم المتحدة الإقليمي لبحوث الجريمة والعدالة، في حديث خاص لمرصد المستقبل، إن «أكثر الأمور خطورة في الذكاء الاصطناعي؛ التطور السريع، فقد نتعرض لمشكلات جراء فقدان التوازن بين سرعة تطور الذكاء الاصطناعي وسرعة قابليتنا للتكيف معها.»

الذكاء الاصطناعي في خدمة المجرمين

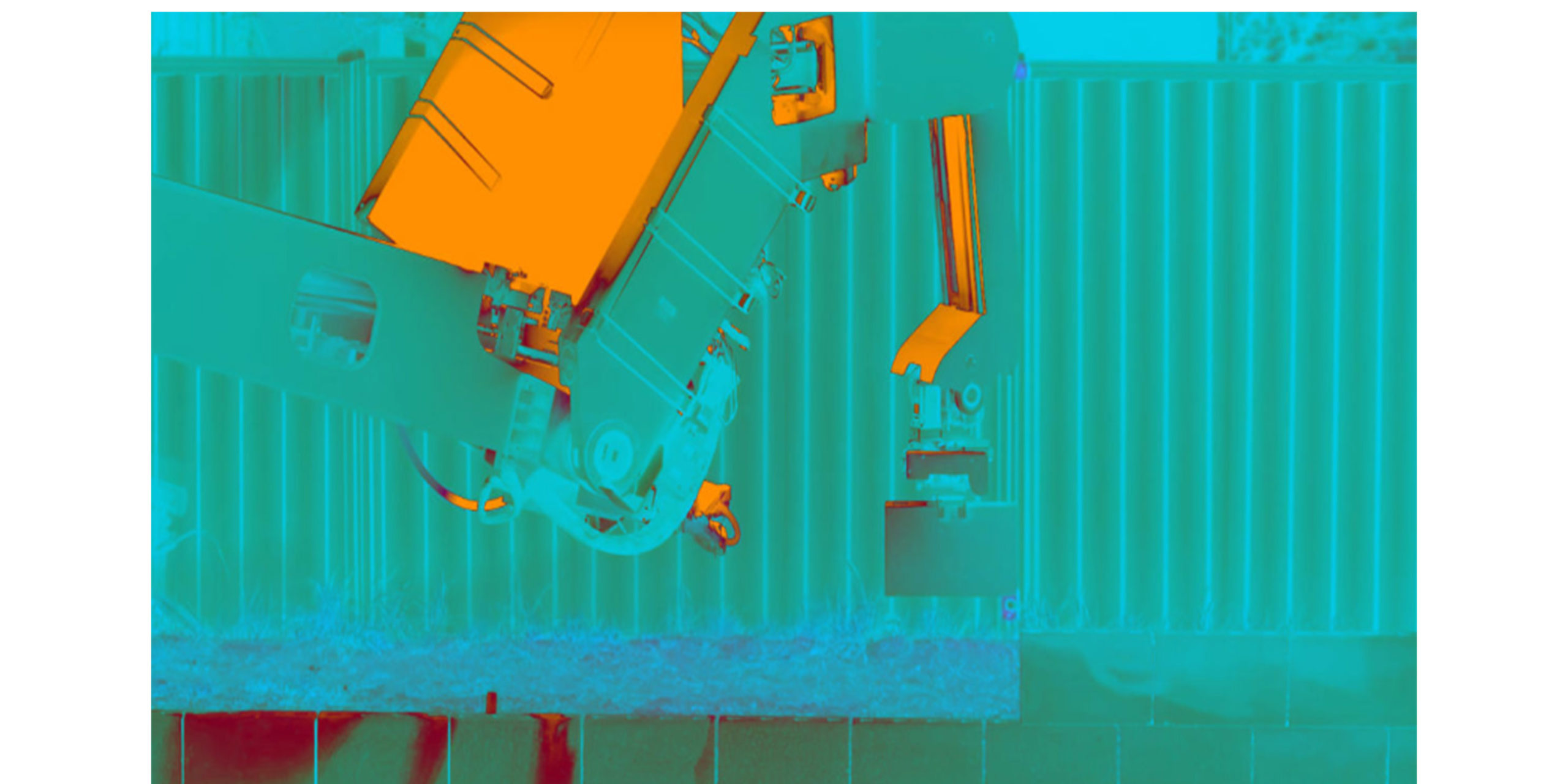

ولم يُخفِ بيريدز مخاوفه من استخدام المنظمات الإجرامية والإرهابية للتطبيقات الخطيرة للذكاء الاصطناعي، بتطويعها لأغراض شريرة وتنفيذ عمليات كبيرة تتسبب بضرر بالغ، من خلال حرب رقمية أو تسخير الذكاء الاصطناعي للتحكم بالروبوتات والطائرات العسكرية دون طيار.

حرمان البشر من الوظائف

وأشار بيريدز إلى مخاطر أخرى متعلقة بخسارة كثير من الأشخاص لوظائفهم لحلول الروبوتات محلهم. وسبق أن سلط خبراء، الضوء على انعكاسات استثمار إمكانيات الذكاء الاصطناعي على سوق العمل في مختلف دول العالم؛ مؤكدين على أن الأعوام القليلة المقبلة ستشهد اختفاء حوالي 47% من الوظائف في الولايات المتحدة وحدها بسبب الذكاء الاصطناعي، وقد يصل اضمحلال الوظائف إلى مليون وظيفة قبل حلول العام 2026.

وبالمقابل يرى بعض صناع القرار أن اختفاء قدر كبير من الوظائف يقابله بوادر ومؤشرات على رفاهية الإنسانية ورخاء المجتمعات، إذ أن الذكاء الاصطناعي من المرجح أن يستحدث مئات الملايين من الوظائف الجديدة في الاقتصادات الناشئة، وقطاعات التطوير التقني، ومجالات الخدمات التخصصية.

سلاح فتاك

وشدد بيريدز على ضرورة استخدام الذكاء الاصطناعي في أمور خيرة، واستثمار فوائده وفهم مخاطره وتخفيفها باعتباره أداة قوية وليس سلاحًا فتاكًا.

وأكد جون لونجفورد الباحث الأساسي في شركة مايكروسوفت، في لقاء مع مرصد المستقبل، على ضرورة مراقبة الطائرات دون طيار، مع وجود احتمالات وطرائق مختلفة لتحولها إلى خطر؛ وقال إن «عملية معالجة المعلومات في الطائرات غير المأهولة ليست فعالة إلى درجة كافية لفعل شيء مفيد حاليًا، لكن في غضون 5 أو 10 أعوام أتخيل أن طائرة دون طيار قد يكون لديها قدرة معالجة داخلية تقدم فائدة في الواقع. إن استخدام الطائرات دون طيار في الوقت الراهن ما زال خاضعًا لسيطرة البشر، لكن ما يثير قلقي هو قدرتها المستقبلية على التعلم العميق.»

الخطر يكمن في سوء الاستخدام

في حين يرى آخرون أن الخطر لا يعود للذكاء الاصطناعي بحد ذاته، بل يكمن في سوء الاستخدام؛ وقال الباحث هافا سيجلمان، مدير برامج تقنية الأنظمة الميكروية في وكالة مشاريع بحوث الدفاع المتطورة (داربا) التابعة لوزارة الدفاع الأمريكية، لمرصد المستقبل، إن «جميع أنواع التقنية قابلة لسوء الاستخدام. أظن أن الأمر بيد من يستخدمها. ولا وجود لتقنية سيئة، بل أشخاص سيئون.»

وقال توماس ميكولوف عالم أبحاث الذكاء الاصطناعي في شركة فيسبوك «عند توفر اهتمام كبير وتمويل ضخم حول شيء معن، يظهر أشخاص مستعدون لإساءة استخدامه. وما يثير القلق هو إقدام بعض الأشخاص على بيع الذكاء الاصطناعي قبل صنعه حتى، مدَّعين معرفة ماهية المشكلة التي سيحلها.»

وأضاف إن «شركات ناشئة تطلق وعودًا عن أشياء تعتبرها من أمثلة الذكاء الاصطناعي الرائعة، إذ تتفنن أنظمتها في تطوير مسار واحد، قد لا يكون مثار اهتمام أحد، وتقضي عشرات الآلاف من ساعات العمل لتحسين قيمة وحيدة، ثم تدعي بعد ذلك بأنها قامت بإنجاز ضخم وتسوق ادعاءات كبيرة بأنها أتت بما لم يسبقها إليه أحد.»

ولسنا متيقنين بعد من إمكانية إنشاء ذكاء اصطناعي عام قادر على أداء أي مهمة إدراكية يستطيع البشر القيام بها ببراعة أو ربما بشكل أفضل.

وعلى الرغم من المستقبل الواعد للذكاء الاصطناعي المتقدم، إلا أنه يظل مقرونًا بجملة من الإشكاليات والأسئلة الأخلاقية، وربما لا نعرف جميع الأسئلة التي يجب الإجابة عنها حتى الآن.

ضمانات مستقبلية

وعلى الرغم من تلك الهواجس إلا أن شريحة واسعة من الخبراء يتفقون على حاجتنا لاتخاذ قرار بشأن قواعد وآليات التعاطي مع الذكاء الاصطناعي قبل أن نصل إلى مرحلة الحاجة الحقيقية لتلك القواعد، مع مراعاة وضع إجابات عن مجموعة من الأسئلة الملحة، حول وقت إنشاء اتفاقيات دولية ومجالس أخلاقية وهيئات تنظيمية في الحكومات والشركات الخاصة والأوساط الأكاديمية، إذ أن وضع الاتفاقيات والبروتوكولات موضع التنفيذ من شأنه أن يقلل فرصة قيام حكومة أو باحث غير معتمد أو حتى عالم مختل، بإطلاق العنان لنظام ذكاء اصطناعي ضار، أو تسليح خوارزميات متقدمة. وإن حصل أمر سيئ فستضمن الأنظمة أن يكون لدينا طرق للتعامل معه.

mostaqbal.ae

0 تعليقات